Régression logistique, diagramme de Voronoï, k-Means¶

Ce qui suit explore les liens entre une régression logistique, les diagrammes de Voronoï pour construire un classifieur qui allie la régression logistique et les clustering type k-means. Le point de départ est une conjecture : les régions créées par une régression logistique sont convexes.

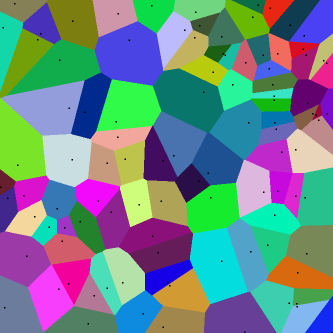

Diagramme de Voronoï¶

Un diagramme de Voronoï

est le diagramme issu des intersections des médiatrices entre points.

On définit un ensemble de points .

La zone d’influence de chaque point est défini par

.

Si d est la distance euclidienne, la frontière entre deux

points

est un segment sur la droite d’équation

:

Ce système constitue droites ou hyperplans si

l’espace vectoriel est en dimension plus que deux.

Le diagramme de Voronoï est formé par des segments de chacune

de ces droites. On peut retourner le problème. On suppose

qu’il existe

hyperplans,

existe-t-il n points de telle sorte que les hyperplans

initiaux sont les frontières du diagramme de Voronoï formé

par ces n points ? Les paragraphes qui suivent expliquent

explorent cette hypothèse.

Régression logistique et classification¶

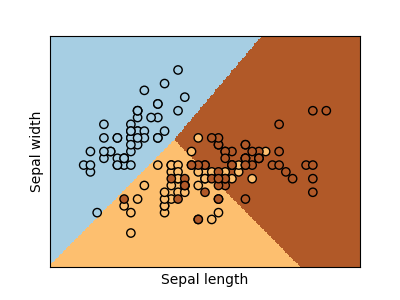

scikit-learn a rendu populaire le jeu de données Iris qui consiste à classer des fleurs en trois classes en fonction des dimensions de leurs pétales.

<<<

from sklearn.datasets import load_iris

data = load_iris()

X, y = data.data[:, :2], data.target

from sklearn.linear_model import LogisticRegression

clr = LogisticRegression()

clr.fit(X, y)

print("coef_", clr.coef_)

print("intercept_", clr.intercept_)

>>>

coef_ [[-2.709 2.324]

[ 0.613 -1.571]

[ 2.096 -0.753]]

intercept_ [ 7.911 1.847 -9.758]

La fonction de prédiction est assez simple :

. La classe d’appartenance

du point x est déterminé par

.

La frontière entre deux classes i, j est définie

par les deux conditions :

.

On retrouve bien

hyperplans.

On définit la matrice A comme une matrice

ligne

où n est le nombre

de classes. L’équation de l’hyperplan entre deux classes devient :

Il y a peu de chance que cela fonctionne comme cela. Avant de continuer, assurons-nous que les régions associées aux classes sont convexes. C’est une condition nécessaire mais pas suffisante pour avoir un diagramme de Voronoï.

Soit et

appartenant à la classe i.

On sait que

et

.

On considère un point

sur le segment

, donc il existe

tel que

et

. On vérifie que :

Donc le point X appartient bien à classe i et celle-ci est convexe. La régression logistique forme une partition convexe de l’espace des features.

Théorème T1 : convexité des classes formées par une régression logistique

On définit l’application

qui associe la plus grande coordonnée

.

A est une matrice

,

B est un vecteur de

,

c est le nombre de parties.

L’application f définit une partition convexe

de l’espace vectoriel

.

Revenons au cas de Voronoï. La classe prédite dépend de

. On veut trouver n points

tels que chaque couple

soit équidistant de la frontière qui sépare leurs classes.

Il faut également les projections des deux points sur

la frontière se confondent et donc que les vecteurs

et

sont colinéaires.

La seconde équation en cache en fait plusieurs puisqu’elle est valable

sur plusieurs dimensions mais elles sont redondantes.

Il suffit de choisir un vecteur non perpendiculaire

à

de sorte que

qu’il n’est pas perpendiculaire au vecteur

et de

considérer la projection de cette équation sur ce vecteur.

C’est pourquoi on réduit le système au suivant qui est

équivalent au précédent si le vecteur

est bien choisi.

Diagramme de Voronoï et partition convexe¶

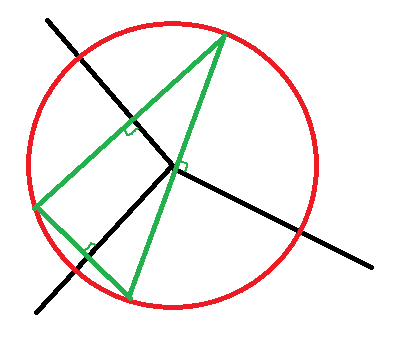

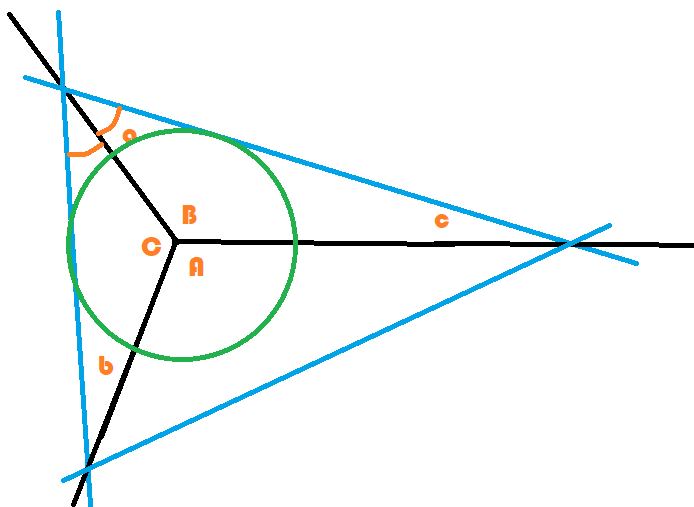

Faisons un peu de géométrie avant de résoudre ce problème car celui-ci

a dans la plupart des cas plus d’équations que d’inconnues.

Chaque frontière entre deux classes est la médiatrice d’un segment

. Le dessin suivant trace un diagramme de Voronoï à

trois points. L’intersection est le centre des médiatrices du triangle

formé par les points de Voronoï. Pour les trouver, on trace un cercle,

n’importe lequel, puis une droite perpendiculaire à l’une des médiatrice.

On obtient deux points. Le troisième est obtenu en traçant une seconde

perpendiculaire et par construsction, la troisième droite est perpendiculaire

à la troisième médiatrice. Et on nomme les angles.

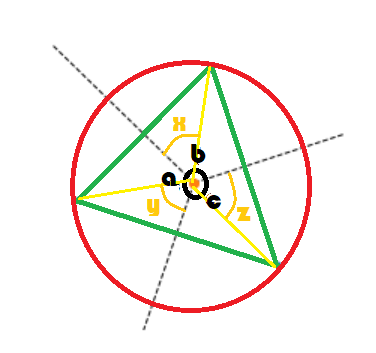

Les triangles formés par les côtés jaunes sont isocèles. On en déduit que

. On en déduit aussi que :

On en conclut que et

. Il existe une infinité de triplets de 3 points

qui aboutissent à ce diagramme de Voronoï. Il suffit de changer

la taille du cercle. On montre aussi qu’en dimension 2 et 3 classes,

il existe toujours une solution au problème posé.

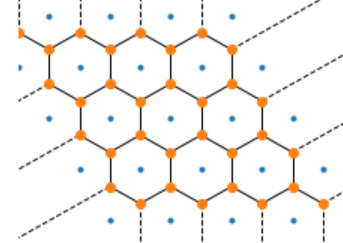

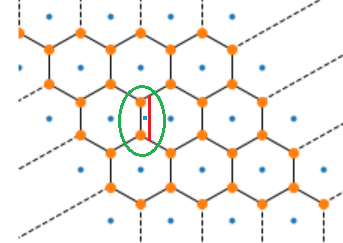

Maintenant, si on considère la configuration suivante avec des points

disposés de telle sorte que le diagramme de Voronoï est un maillage

hexagonal.

et

.

Il n’existe qu’un ensemble de points qui peut produire ce maillage

comme diagramme de Voronoï. Mais si on ajoute une petite zone

(dans le cercle vert ci-dessous), il est impossible que ce diagramme

soit un diagramme de Voronoï bien que cela soit une partition convexe.

On revient à la détermination du diagramme de Voronoï associé à une régression logistique. On a montré qu’il n’existe pas tout le temps pour n’importe quelle partition convexe. Mais cela ne veut pas dire que tel est le cas pour une régression logistique.

Régression logistique et partition convexe¶

On a montré que la régression logistique réalise une

partition convexe de l’espace vectoriel des variables.

On note L(n) l’ensemble des partitions à n classes.

Le diagramme de Voronoï correspondent également à un

sous-ensemble V(n). , that is the

question.

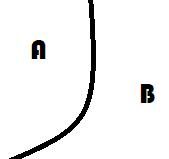

On peut se poser la question de savoir si L(n) un sous-ensemble ou tout l’ensemble auquel cas la réponse à la question précédente est triviale. Considérons d’abord deux parties voisines d’une partition convexe formée par une fonction telle que celle décrite par le théorème sur la convexité des classes formées par une régression logistique.

L’image qui précède montre une partition qui n’est pas convexe.

La partie A l’est mais pas la partie B. En fait, il est facile

de montrer que la seule frontière admissible entre deux parties convexe

est un hyperplan. Si la partition contient n partie,

il y a au pire frontières,

ce qui correspond également au nombre d’hyperplans définis

par la fonction de prédiction associée à la régression logistique.

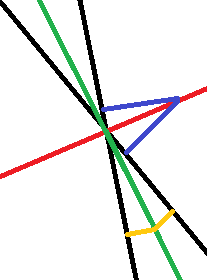

L’image qui précède présente une classification en trois

zones (droites noires). On a choisi une droite bleue au hasard.

En prenant son symétrique par rapport à une des droites noires (D),

on a deux droites ,

. L’ensemble des points

correspond à la droite noire.

Il doit être de même pour les trois droites bleues, autrement

dit, l’intersection des droites est le centre du cercle inscrit

dans le triangle bleu ce qui n’est visiblement pas le cas sur l’image.

Il paraît vraisemblable de dire que les régressions logisitiques ne permettent

pas de former toutes les partitions convexes. On pourrait le montrer mais

cela ne permettrait pas de répondre à la question initiale

?

Voronoï et régression logistique¶

On sait que quelque soit la dimension,

que

en dimension 2. La matrice L

définit une régression logistique. Le diagramme de Voronoï qui

lui correspond est solution du système d’équations qui suit :

(1)¶

Avec choisi de telle sorte que les

vecteur

et

ne soit pas

coliénaires. Ce système inclut des équations

entre classes ou régions qui ne sont pas voisines.

Il y a potentiellement

équations pour n inconnues. Il n’est pas évident de dire

si ce système à une solution. Voyons plutôt l’ensemble des droites

formées par un diagramme de Voronoï. Un point appartient à un segment

s’il est à égale distance de deux points.

Pour une partition convexe formée à partir de droite, comme c’est le cas d’une régression linéaire, un point appartient à un segment s’il est à égale distance de deux droites. L’ensemble de ces points correspond à deux droites, les deux bissectrices.

Seule l’une de ces droites est la bonne.

L’équation d’une droite est donnée par

.

On choisit l’une de ces droites.

On peut voir que si tous les points sont situés

sur la boule unité, à savoir ,

la régression logistique s’écrit simplement avec

et

.

On revient au système d’équations linéaires

(1) et on en cherche une solution

approchée un peu à la façon

RANSAC

avec une régression linéaire et la norme L1.

Il n’existe pas toujours de diagramme de Voronoï équivalent

à la partition convexe réalisée par une regréssion logistique.

Il est facile de trouver un contre-exemple en essayant de résoudre

le système précédent. C’est ce que fait la fonction

voronoi_estimation_from_lr.

La fonction essaye avec quelques approximations et heuristiques

de déterminer les points du diagramme de Voronoï. Si elle réussit

du premier coup, c’est qu’il y avait équivalence ce qui arrive peu souvent.

Il faudrait refaire les calculs à la main et non de façon approchée pour

valider un contre exemple. Une prochaine fois peut-être.

Ce qu’il faut retenir est que la régression logistique

réalise une partition convexe de l’espace des variables.

Notebooks¶

Le notebook qui suit reprend les différents éléments théoriques présentés ci-dessus. Il continue l’étude d’une régression logistique et donne une intuition de ce qui marche ou pas avec un tel modèle. Notamment, le modèle est plus performant si les classes sont réparties sur la boule unité de l’espace des features.